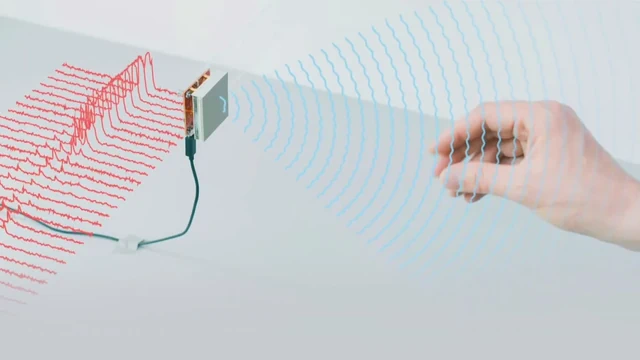

Mit Radar kann man schon lange Flugzeuge lokalisieren oder die Geschwindigkeit eines vorbeifahrenden Autos messen. Nun kommt eine weitere Anwendung dazu: Das Smartphone mit Gesten steuern, ohne das Gerät dabei zu berühren.

Wie das geht, zeigt Google in einem Video: Eine Wischbewegung mit der Hand reicht und das Smartphone spielt den nächsten Song ab. Lässt man den Zeigefinger über den Daumen gleiten wie bei einem Drehknopf, so verändert man die Lautstärke.

Vom abstrakten Signal zur Geste

An der Entwicklung dieses Radar-Chips, der nun in den neuen Google-Smartphones steckt, waren Wissenschaftler der ETH Zürich massgeblich beteiligt. Sie haben Software entwickelt, die die Radar-Daten analysiert und darin Gesten erkennt – ein komplexer, mehrstufiger Vorgang.

«Wir bekommen vom Chip ein eindimensionales Signal, das uns nur sagt, dass sich in einer bestimmten Distanz zum Chip etwas bewegt», sagt Othmar Hilliges, Professor für Informatik an der ETH Zürich.

Sein Team hat ein Verfahren entwickelt, das aus diesem Signal zusätzliche Information auslesen kann. Die Software ist nun in der Lage, aufgrund der Radarwellen zwischen verschiedene Gesten zu unterscheiden, die jemand mit seinen Händen vor dem Gerät ausführt.

Künstliche Intelligenz am Werk

Möglich machen es neuronale Netze, auch bekannt als «Deep Learning»: Dabei zeigen die Forscher dem Computer Radar-Signale zusammen mit der Information, welche Geste jeweils dahinter steckt. Die Maschine findet selber heraus, wie sie die Daten umformen muss, damit sie erkennen kann, um welche Geste es sich handelt.

Das Verfahren arbeitet mit gleich zwei solchen Netzen: Im ersten wird das Signal so umgeformt, dass das zweite Netz aufgrund der zeitlichen Entwicklung entscheiden kann, um welche Geste es sich handelt. Der Computer hat also selber gelernt, wie er welche Radarwellen mit einer bestimmen Geste assoziieren muss. Ist das nun das Ende der Touchscreens?

Es ist kompliziert

Hans-Peter Hutter, Professor für Informatik an der ZHAW, dämpft die Erwartungen. Will man ein Gerät mit Gesten kontaktlos steuern, so habe man es mit verschiedenen Problemen zu tun, erklärt der Spezialist für die Mensch-Maschine-Kommunikation:

- Wann beginnt eine Geste? Auf einem Touchscreen löst eine Berührung eine Aktion aus, bei kontaktlosen Gesten ist das nicht klar – gestikuliert eine Nutzerin einfach während eines Gespräches oder will sie das Gerät bedienen?

- Welche Gesten stehen mir zur Verfügung, um bestimmte Aktionen auszulösen? Auf dem Touchscreen geht aus dem Kontext hervor, welche Interaktion möglich ist. Bei berührungslosen Gesten muss man sich die Bedienung antrainieren und die einzelnen Schritte auswendig lernen.

Hans-Peter Hutter sieht dennoch ein gewisses Potenzial für einen präzisen Radar-Sensor in einem mobilen Gerät. So liesse sich damit etwa die Gebärdensprache hörbehinderter Menschen erfassen. Oder der Sensor könnte die Übungen in einer Physiotherapie-Sitzung analysieren und abschätzen, ob die Bewegungen korrekt durchgeführt wurden.

Welche Vorteile der neue Sensor der breiten Masse der Smartphone-Nutzer bringen wird, ist auch für den Experten nicht offensichtlich: «Einmal mehr wirft ein Grosskonzern Hardware auf den Markt und schaut dann mal, was passiert», beschreibt der Informatiker seine spontane Reaktion auf die Ankündigung des Soli Radar-Chips.

Sendebezug: Radio SRF 4 News, 16.10.2019, 8:17 Uhr.